Apple は ARKit 4 を使用して、ポケットに新しい iPhone を入れていれば誰でも探索できる、アニメーション化されたインタラクティブな 3D 「現実」の仮想世界の基盤を構築しています。

WWDC20 で Apple は、今後提供される未来的な新機能について概説しました。ARKit4. 同社の拡張現実プラットフォームの以前のリリースでは、まず、基本的な 3D グラフィックスを、iOS 11 カメラからのビデオ ストリーム内の所定の位置に固定して表示できるようにしました。視覚慣性オドメトリ。これにより、ユーザーは仮想オブジェクトを四方八方から探索したり、AR を介してテーブル表面に固定されたインタラクティブ ゲームをプレイしたりすることができます。

2018 年の iOS 12 の ARKit 2 では、共有 AR ワールドが導入され、2 人のユーザーが同じ仮想シーンの異なるビューを見ることができ、拡張現実アプリでのマルチユーザー ゲームプレイが可能になりました。昨年の ARKit 3 ではモーション キャプチャとピープル オクルージョンが導入され、カメラの前で人がどのように配置されているかを理解しながら、仮想オブジェクトが人の前後で移動できるようになりました。

アップルのAR および関連テクノロジーのコレクションへの投資コンピューター ビジョン、機械学習、およびモーション検出を使用して、カメラ ビュー内の所定の位置に固定された、ますます洗練されたインタラクティブなコンピューター グラフィックスの世界を構築します。それは最終的に、販売のための競争的な取り組みよりもはるかに成功し、影響力のあるものになりました。スマホVRここ数年にわたって。

ロケーションアンカー

発表されたばかりのARKit 4iOS14ロケーション アンカーを追加します。これは、緯度、経度、標高によって定義される現実世界の特定の場所に AR モデルを固定できます。これは、Apple がサンフランシスコのフェリー ビルディングに設置した KAWS の設置で実証したように、仮想アートワークを提示するために使用できます。また、空間内の特定の場所に固定されたラベルを配置したり、特定の場所で AR エクスペリエンス全体を構築したりするために使用することもできます。

GPS だけで提供できるよりも高い精度で位置を固定するために、Apple はビジュアル ロケーションを使用した ARKit 4 のデモンストレーションを行いました。これは、機械学習を使用して、カメラで捉えられたランドマークと、現在の位置に対応する Apple Maps からダウンロードされたローカリゼーション マップを照合します。これは、主要都市で探索可能な Look Around Maps を構築するために Apple Maps 車両によって収集されたデータと思われます。

位置照合プロセスは携帯電話上でローカルに実行され、個人情報が Apple のサーバーに返送されることはありません。この印象的なテクノロジーの交差点は、Apple Pay を使用した支払いや「Apple でサインイン」を使用したユーザー ログインなどのインスタント機能を提供する App Clip など、Apple が WWDC20 で詳しく説明してきた他の機能とさらに組み合わせることができる可能性があります。

これらのテクノロジーの将来のアプリケーションは、噂の「アップルグラスこれにより、興味のあるポイントをナビゲートし、ユーザーがアンカーされた AR エクスペリエンスと対話して、より多くの情報を見つけたり、さまざまな高度なアプリ トランザクションを処理したりできるようになります。

Depth API と LiDAR

AR エクスペリエンスを現実世界の固定点に固定することに加えて、ARKit 4 は、新しい Depth API による高度なシーン理解機能も提供するようになりました。これにより、最新の LiDAR スキャナーを使用できるようになります。iPad Pro—そして、これは次の映画に登場すると噂されていますiPhone12モデル - 周囲環境の深度情報の詳細なメッシュを迅速に取得します。

最初にカメラでシーンをスキャンするのではなく、LiDAR を使用すると、部屋内の現実世界のオブジェクトと対話するゲームなどの AR エクスペリエンスに仮想オブジェクトを即座に配置できます。

新しいシーン ジオメトリ API は、環境のトポロジ マップを作成できます。これを意味分類と併用して、物理オブジェクトを識別し、床、壁、その他のオブジェクトを区別し、シーン内のオブジェクトの深さとそれらがどのように配置されているかを理解できます。手配されました。

ARKit 4 は、シーン内の遮蔽された人物や識別されたオブジェクトの前後に仮想オブジェクトを配置できます。ゲーム物理学を使用して、仮想オブジェクトと物理オブジェクト間の現実的な相互作用をシミュレートします。レイキャスティングを使用して現実的な光を作り、現実と現実を拡張するデジタル コンテンツの間の境界線を曖昧にします。

顔と手の追跡

ARKit 4 の 3 番目の大きな進歩により、顔追跡が TrueDepth カメラを搭載したデバイスを超えて新しいデバイスに拡張されます。iPhone SE少なくとも A12 Bionic プロセッサを搭載したその他の製品。

フェイス トラッキングは、フェイス アンカーとジオメトリをキャプチャして、ユーザーの顔にグラフィックスを適用できるようにします。これにより、ユーザーの表情をキャプチャして仮想キャラクターをアニメーション化するミー文字のようなアバターを作成したり、仮想メイクアップやポートレート ライティングに似たその他の照明効果を適用したりできます。 iOSカメラで。

アップルも追加したハンドトラッキングこれにより、iOS デバイスは全身の動きだけでなく、手の指の個々のポーズも認識できるようになります。あるデモンストレーションでは、カメラが正確な手の動きを監視して識別するだけで、ユーザーが空中で単語を綴ることができる方法を示しました。

Apple はまた、外部のデジタル コンテンツ作成ツールで開発された 3D モデルを ARKit で使用される usdz ファイル形式に取り込むための新しい Reality Converter アプリと、AR エクスペリエンスを構築およびテストし、AR エクスペリエンスをエクスポートして戻すための Reality Composer のアップデートも提供しています。ポータブル米ドル。

RealityKit は、発光、アルファ、テクスチャの粗さなどのリアリズム属性を備えた、壁に置かれた仮想テレビなどの ARKit シーン内にビデオ テクスチャを適用するためのサポートも追加します。

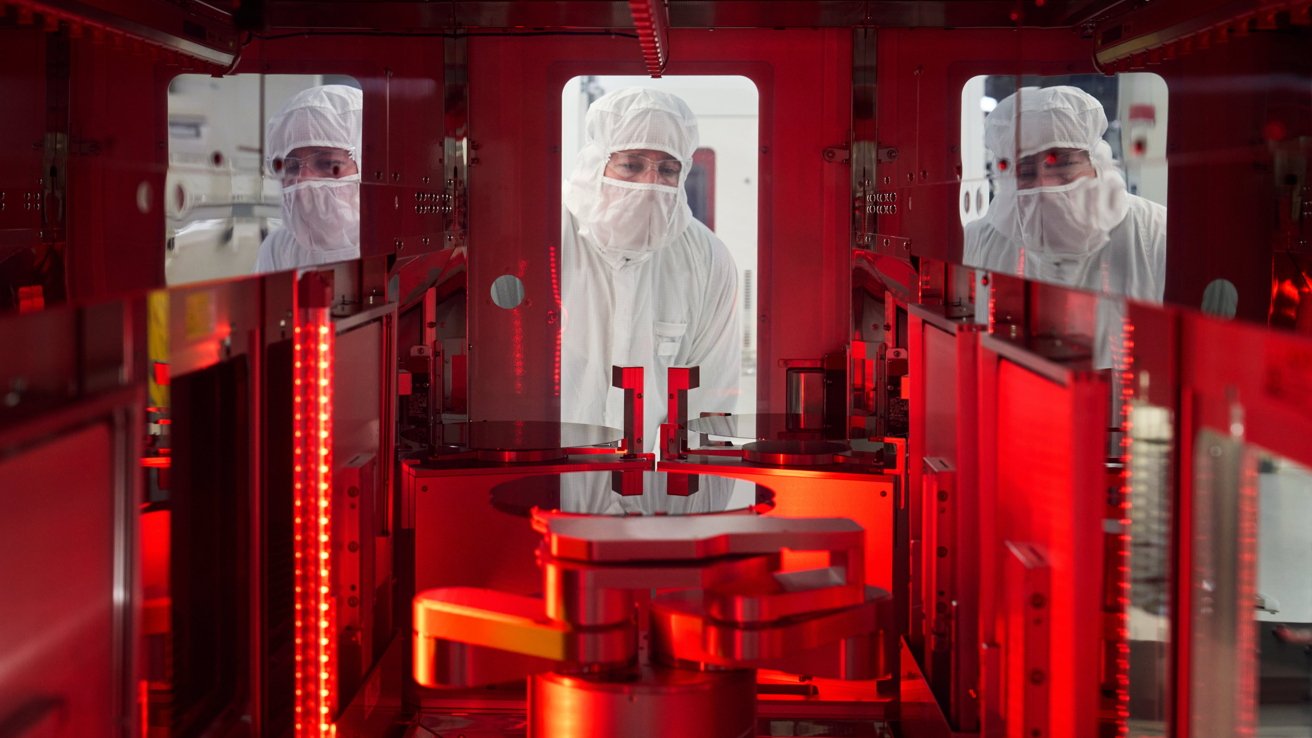

Apple が AR で行っている取り組みは、他の企業、特に Google が始めている既存の取り組みと重複しています。しかし、Apple の AR への取り組みを劇的にサポートしているものの 1 つは、iPhone X 以降の TrueDepth や新しい iPad Pro の新しい LiDAR センサーなどの構造センサーを備えた、ハイエンドで洗練されたデバイスの同社の広大なインストールベースです。

Apple は 3 年前に ARKit を立ち上げ、すぐに世界最大の AR プラットフォームになりました。これは、開発者が現実世界の多数のユーザーが体験できるエクスペリエンスを構築するさまざまな機会があることを意味します。同社はまだスタートしたばかりで、ARKit の機能を新しい方向に拡張する新技術の導入がさらに進むことが予想されます。これには、iOS および iPadOS ハンドヘルド モバイル デバイスの現在のインストール ベースに加えて、ウェアラブル グラスや車のフロントガラスなども含まれる可能性があります。