visionOS は、Apple の空間コンピューティング用プラットフォームです。これは、Apple Vision Pro 上で実行されるソフトウェアを駆動し、この分野における Apple 製品の中心として機能します。

● 空間コンピューティング オペレーティング システム

● AR および VR モードで利用可能な無限の空間キャンバス

● ウィンドウとスペースで表示できる 3D アプリとコンテンツ

● SwiftUI と RealityKit で構築されたアプリ

● iPad および iPhone アプリは開発者の介入をほとんど必要とせずに動作します

● 目と手のコントロール

● 物理キーボード、トラックパッド、ゲーム コントローラーをサポート

アップルが発表アップルビジョンプロその間WWDC2023 年とそれに対応するオペレーティング システム、visionOS。これは、空間コンピューティング用に構築された Apple の最初のプラットフォームです。

ユーザーを別の世界に転送することに重点を置いた独立した VR ヘッドセットや、アプリを現実世界に重ねる限定的な AR グラスのセットを構築する代わりに、Apple は両方を組み合わせたものを選択しました。主に、visionOS は、完全な分離であっても、ソーシャルフレンドリーな拡張コンピューティングであっても、ユーザーのニーズに適応できる複合現実オペレーティング システムです。

ホーム ビューは、アプリ ランチャーおよび環境ピッカーとして機能することにより、オペレーティング システムの中心として機能します。フローティングアイコンとアプリウィンドウは部屋の光を反射し、影を落とします。

Apple Vision Pro は、visionOS を実行する Apple の最初の製品ですが、これが最後ではありません。噂によると、最終的にはARグラスと呼ばれるセットに電力を供給することになると予想されていますアップルグラス。

ビジョンOS 2.0

ビジョンOS 2これには、新しいナビゲーション ジェスチャやより優れた Safari ビデオ プレーヤーなど、いくつかの新しい生活の質の改善が含まれています。

アップルが明らかにアップルインテリジェンス同様ですが、Apple Vision Pro の発売時には搭載されません。これは将来のvisionOS 2アップデートやvisionOS 3に含まれる可能性がありますが、プラットフォームに導入される予定です。

開発者は、空間エクスペリエンスや 3D アプリを作成するための API をさらに利用できます。ユーザーは 2D 写真を立体効果のある空間 3D 写真に変換でき、ホーム ビューを再編成できます。

新しいジェスチャは、最初の OS バージョンからの苦情に対処するのに役立ちます。ユーザーは手の甲に目を向けてホーム ビューを開くボタンを探したり、手を裏返すとコントロール センターを開くステータス バーを確認したりできます。

VisionOS: 空間への移行

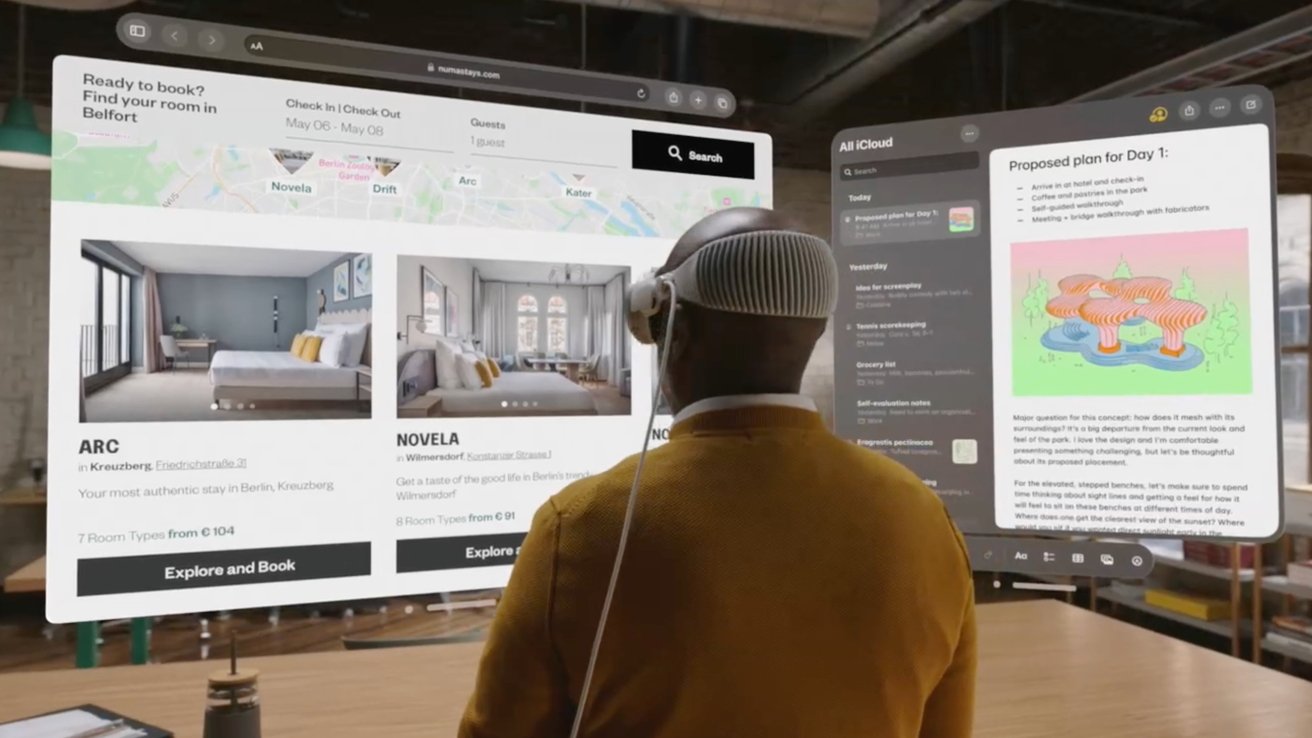

visionOS は、3D 空間にアプリを配置するための無限のキャンバスをユーザーに提供します。アプリは 2D ウィンドウとして表示したり、オーナメントと呼ばれる 3D オブジェクトを含めたり、没入型ビューでスペースを満たすように拡張したりできます。

デザイン

既存のアプリのようなものサファリは空中に浮かぶ 2D ウィンドウとして表示されますが、拡張メニューとウィンドウの外側に浮かぶアドレス バーがあります。 iPadとiPhoneアプリは、ディスプレイ上でアプリを表示するのと同様に、ウィンドウの境界に制限されます。

ホーム ビューでは、スペースまたは没入型ビュー内にアイコンを配置します。

ホーム ビューでは、スペースまたは没入型ビュー内にアイコンを配置します。

ホームビューは次のものを組み合わせたもののように見えますテレビOSそしてウォッチOS。グリッド状に配置された丸いアイコンは、操作したり眺めたりすると 2.5D 効果が現れます。

カメラはユーザーの周囲の部屋をキャプチャし、それを内部ディスプレイに渡します。 Apple Vision Pro をオンにすると、ユーザーは奥行きのある現実世界のほぼ完璧な表現を見ることができます。

オブジェクトとウィンドウは、配置アンカー、影、透明度によって物理的に存在しているように見えます。ARKitエクスペリエンスの開発に役割を果たしますが、3D シーンは次の方法で構築する必要があります。SwiftUIそしてRealityKit。

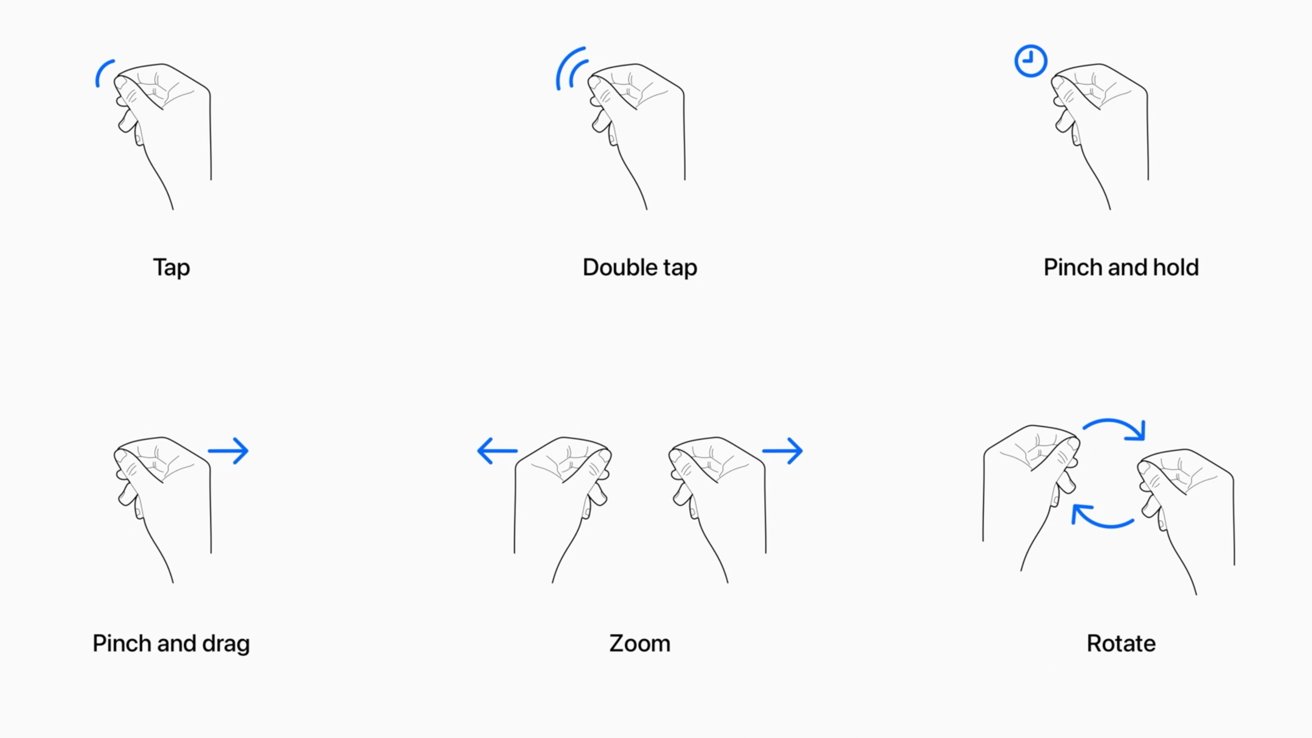

ジェスチャーとコントロール

手のジェスチャー、視線追跡、および音声制御により、追加のハードウェアを必要とせずにソフトウェア操作が可能になります。仮想キーボードがありますが、ユーザーは Bluetooth キーボード、Magic Trackpad、または Mac のユニバーサル コントロールを入力に利用できます。

シンプルなジェスチャーでアプリとエクスペリエンスをコントロール

シンプルなジェスチャーでアプリとエクスペリエンスをコントロール

アイトラッキングを使用すると、ユーザーは操作したいオブジェクトを見ることができます。オブジェクトの選択または掴みは、指でつまむ動作で実行されます。

テキスト フィールドを見て、ピンチして、話すか入力して入力します。マイク アイコンを見たときに音声によるテキスト化を有効にする設定は、デフォルトで有効になっています。

オブジェクトは、ユーザーがどこにいるのか、ユーザーの手が何をしているのかを理解し、さらなるインタラクションを可能にします。たとえば、手を差し出すと、仮想の蝶が指に止まる可能性があります。

デジタルクラウンとトップボタンを数秒間押し続けると、アプリを強制終了できます。または、トラッキングがオフになっているように見える場合は、トップボタンを 4 回連続で押して再調整してください。

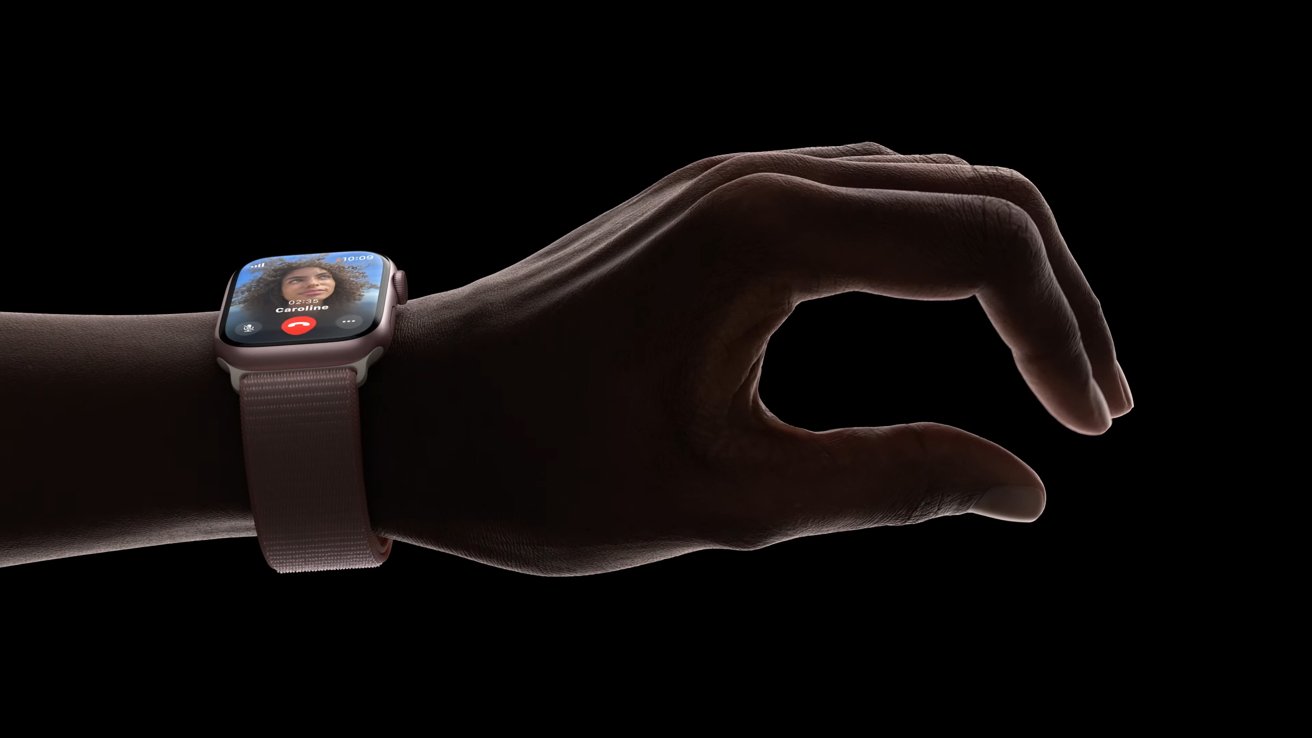

Apple Watchをダブルタップします

Apple Watchをダブルタップします

Apple は、同様のジェスチャを導入することで、Apple Vision Pro でのダブルタップに対するユーザーの準備を整えているようです。アップルウォッチシリーズ9そしてアップルウォッチウルトラ2。ユーザーが親指と別の指でピンチ動作を 2 回実行すると、デバイス上のアクティブなボタンがアクティブになります。アップルウォッチ。

Apple Watch のダブルタップは、高度なアルゴリズムと複数のセンサー信号を処理する S9 SiP のおかげで可能です。 Apple Vision Pro はカメラを使用してジェスチャを解釈できますが、Apple Watch は将来のアップデートでその制御機能に別の要素を追加する可能性があります。

フェイスタイム

ユーザーの顔はヘッドセットで隠されていますが、フェイスタイムApple Vision Pro では引き続き可能です。他の参加者はフローティング ウィンドウを通して見ることができ、自分はペルソナ (自分自身のデジタル表現) を通じて表示されます。

FaceTimeはvisionOSの機能です

FaceTimeはvisionOSの機能です

ユーザーのペルソナは、Apple Vision Pro カメラで顔をスキャンすることによって作成されます。 3D モデルはユーザーに似ていますが、完全にコンピューターで生成されているため、不気味の谷の要素があります。

FaceTime 通話中に、最大 9 つのフローティング ウィンドウを表示できます。通常の参加者制限は 32 名のままですが、全員が表示されるわけではありません。

空間ビデオ

の所有者iPhone 15 Pro または iPhone 15 Pro Max走っているiOS17.2Apple Vision Pro で表示できる空間ビデオを録画できます。 1080p、30Hzで記録された3Dビデオです。

iPhone で空間ビデオをキャプチャする

iPhone で空間ビデオをキャプチャする

Apple Vision Pro を装着したまま空間ビデオを録画することもできます。ただし、特に社会的な環境では、それは少し厄介かもしれません。

解像度とフレーム レートは理想的ではありませんが、ヘッドセットでのエクスペリエンスが低下することはありません。将来の iPhone では、より高品質の 3D ビデオを録画できるようになるはずですが、現在キャプチャされているものは、Apple Vision Pro 内で表示するのに十分です。

メインカメラと超広角カメラを使用して光学的に分離されたビデオをキャプチャすることで、3D 効果が可能になります。各ビデオがヘッドセットの個別のディスプレイで再生されると、正しくキャプチャされている限り、ユーザーの目は 3D ビデオを見ることができます。

Apple TV アプリでは 3D 映画も提供しています。 Apple によれば、発売時には 150 以上の 3D タイトルが、少数の 8K 完全没入型ビデオとともに利用可能でした。

安全

Apple Vision Pro には、新しい種類の生体認証セキュリティである Optic ID が搭載されています。ユーザーの虹彩をスキャンして、ログインや購入などを認証します。

Optic ID がユーザーの虹彩をスキャンします

Optic ID がユーザーの虹彩をスキャンします

人が使用するあらゆる場所でタッチIDまたは顔認証ここで Optic ID が機能します。他の生体認証システムと同様に、虹彩データは暗号化されて Secure Enclave に保存されるため、デバイスの外部に流出することはありません。

Apple はまた、アプリがデバイスのカメラやセンサーから貴重なデータを取得することを阻止します。アイトラッキングとビデオパススルーはアプリの使用中に発生しますが、サードパーティのデータ収集のためにアクセスできない別のレイヤーで発生します。

iPhone や iPad と同様に、Optic ID を使用して何かを認証するとき、ユーザーはトップ ボタンを 2 回押して確認します。これにより、支払いフィールドを見ただけで誤って承認されることを防ぎます。

発達

Apple は、開発者がvisionOS 用のアプリやコンテンツを作成する際に従うべき明確な道を切り開いてきました。ただし、開発者は立ち上げ時に限られた対面セッションまたは Xcode のシミュレーター ツール経由でのみアクセスできるという制限がありました。

発売当時、Vision Pro で利用できるネイティブ アプリはわずか約 600 でした。顧客と開発者の両方がハードウェアを利用できるようになると、より多くのアプリが合理的な速さでプラットフォーム向けにリリースされることになります。

SwiftUI は空間コンピューティングのコーディングの基盤です。深度、ジェスチャー、エフェクト、シーンをサポートする 3D 対応ツールがあります。

RealityKit は、開発者に 3D コンテンツ、アニメーション、視覚効果を生成する機能を提供します。物理的な照明条件に調整して影を落とすことができます。

フローティングウィンドウはどこにでも配置可能

フローティングウィンドウはどこにでも配置可能

ARKit は、平面推定やシーン再構成などを使用して、アプリが人の周囲を理解するのに役立ちます。これにより、アプリは物理的な壁や床がどこにあるのかを理解できるようになります。

ただし、ARKit で構築されたアプリは自動的に 3D レンダリングされません。実際、iPhone 用に構築された AR アプリがvisionOS で実行されると、iPhone 上にあるかのようにコンテンツを表示する 2D 平面として表示されます。

![]() visionOS ではアイコンも 2.5D 処理されます

visionOS ではアイコンも 2.5D 処理されます

開発者は、3D コンテンツについては RealityKit を最初から使用する必要があります。つまり、少なくとも任天堂とナイアンティックが専用のアプリを開発するまでは、まだ完全な AR 体験を使ってリビングルームでポケモンを捕まえることはできないでしょう。

Apple は、自社の空間コンピューティング プラットフォームに対して業界全体の用語を使用することを避けていることに注意してください。 2D アプリは「ウィンドウ」と呼ばれ、3D オブジェクトは「ボリューム」と呼ばれ、完全な環境は AR オブジェクトや VR エクスペリエンスのような用語の代わりに「スペース」と呼ばれます。

visionOSのリリースとその将来

空間コンピューティングは Apple にとって新しい領域であり、製品とソフトウェアが成熟するには時間がかかるでしょう。 Apple Vision Proは2024年の始まりにすぎず、標準のApple Visionモデルは2026年に低価格で、最終的にはARグラスになる予定です。

Appleは2月2日にオペレーティングシステムvisionOSとともにApple Vision Proをリリースした。 visionOS 2 のベータ版は進行中で、最終リリースは 2024 年 9 月中旬に予定されています。