iPhone 上でのスキャンによって児童の性的虐待の内容を追跡するという物議を醸した Apple の計画は中止されたが、同社はそれを根源から阻止する別の計画を念頭に置いている。

アップルが発表2つの取り組み2021年後半には、子どもたちを虐待から守ることを目的とした。 1つは、今日すでに施行されています。警告するだろう未成年者は、ヌードコンテンツを含む写真を送受信する前に注意してください。これはアルゴリズムによるヌード検出を使用して機能し、子供にのみ警告します。親には通知されません。

2 番目の、より物議を醸している機能は、ユーザーの iPhone 上の iCloud にアップロードされているユーザーの写真を分析して、既知の CSAM コンテンツがないかどうかを分析します。分析は、ハッシュ システムを使用してデバイス上でローカルに実行されました。

~からの反発の後プライバシーの専門家、児童安全グループ、 そして政府、 りんご機能を一時停止しました無期限にレビューのために。水曜日、アップルは声明を発表した。AppleInsiderそして他の会場では、その機能を完全に放棄したと説明しています。

「昨年提案した児童保護の取り組みについてのフィードバックを収集するために専門家と広範な協議を行った後、2021年12月に初めて利用可能にしたコミュニケーションセーフティ機能への投資をさらに深めています。」「私たちはさらに、以前に提案した iCloud 写真用の CSAM 検出ツールを進めないことを決定しました。企業が個人データを精査しなくても子供たちは保護できます。私たちは引き続き政府、児童擁護団体、その他の企業と協力して若者の保護を支援していきます」プライバシーの権利を守り、インターネットを子供たちと私たち全員にとってより安全な場所にします。」

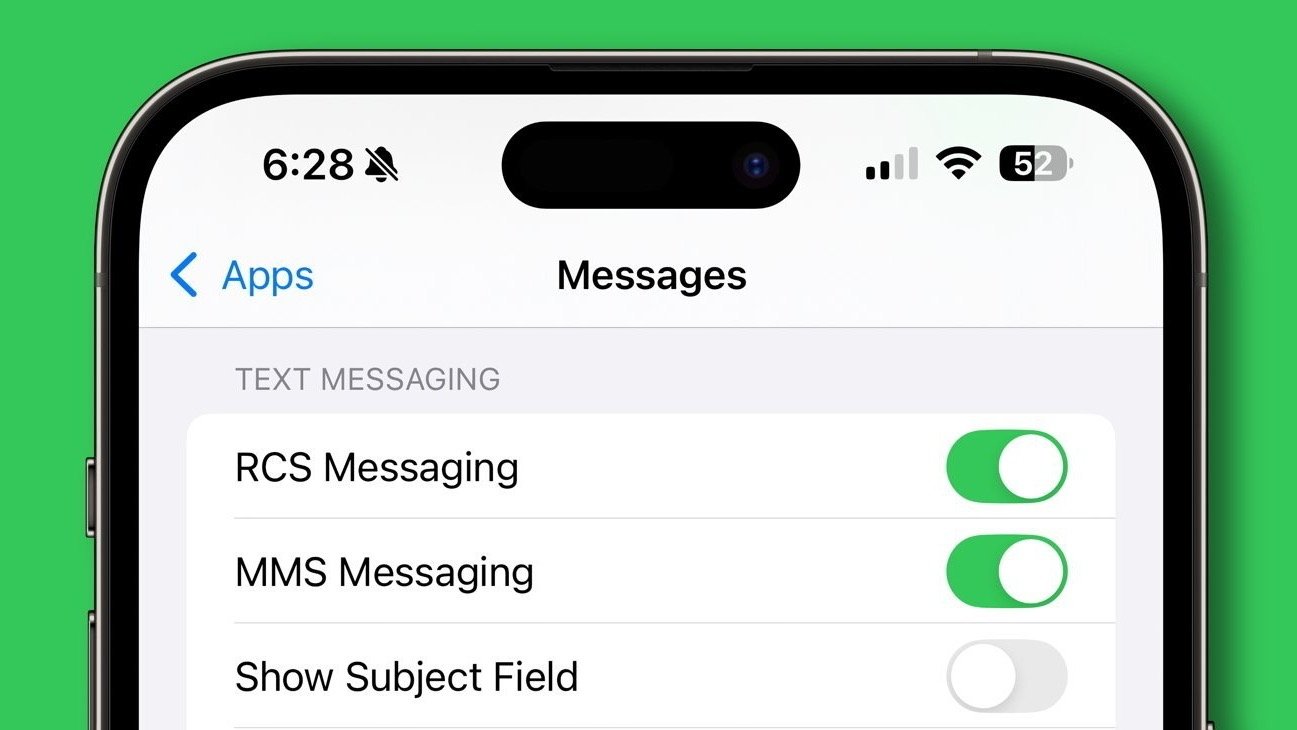

この発言はその直後に来るアップルが発表さらに多くの iCloud データをエンドツーエンドで暗号化する新機能。iメッセージ内容も写真も。これらの強化された保護により、Apple の CSAM 検出機能の主要な部分であるサーバー側のフラグ システムが不可能になったでしょう。

異なるアプローチをとる

Amazon、Google、Microsoft などは法律の要件としてサーバー側のスキャンを実行していますが、エンドツーエンドの暗号化により Apple はそれを実行できません。

代わりに、Apple は問題の根源、つまり作成と配布で問題に対処したいと考えています。 Appleは、コンテンツをクラウドサーバーに溜め込む人々をターゲットにするのではなく、ユーザーを教育し、そもそもコンテンツが作成され送信されるのを阻止したいと考えている。

Appleが提供する追加の詳細この取り組みについて有線。機能のスケジュールは明らかにされていないが、通信の安全性機能として、アルゴリズムによるヌード検出をビデオに拡張することから始まるだろう。 Apple はその後、これらの保護を他のコミュニケーション ツールにも拡張し、開発者にもアクセスを提供する予定です。

Appleはまた、「子どもを危険な通信から守るためのオプトインツールを親に提供することで、子どもの搾取の可能性を事前に阻止できる」と声明で述べた。 「Appleは、個人の通信やデータストレージに特有のプライバシーのニーズに対処しながら、児童性的虐待と闘い、子供を保護するための革新的なプライバシー保護ソリューションの開発に専念しています。」

Siri、Safari、Spotlight には、ユーザーが CSAM を検索したときを検出する他のオンデバイス保護機能があります。これにより、検索は個人に支援を提供するリソースにリダイレクトされます。

プライバシーを保護しながらユーザーを教育する機能は、数十年にわたる Apple の目標でした。子供の安全のための既存の実装はすべて通知を求めており、Apple は安全機能がいつトリガーされるかを決して知りません。